撰稿/吳思儒

編輯/楊淳

2025.06

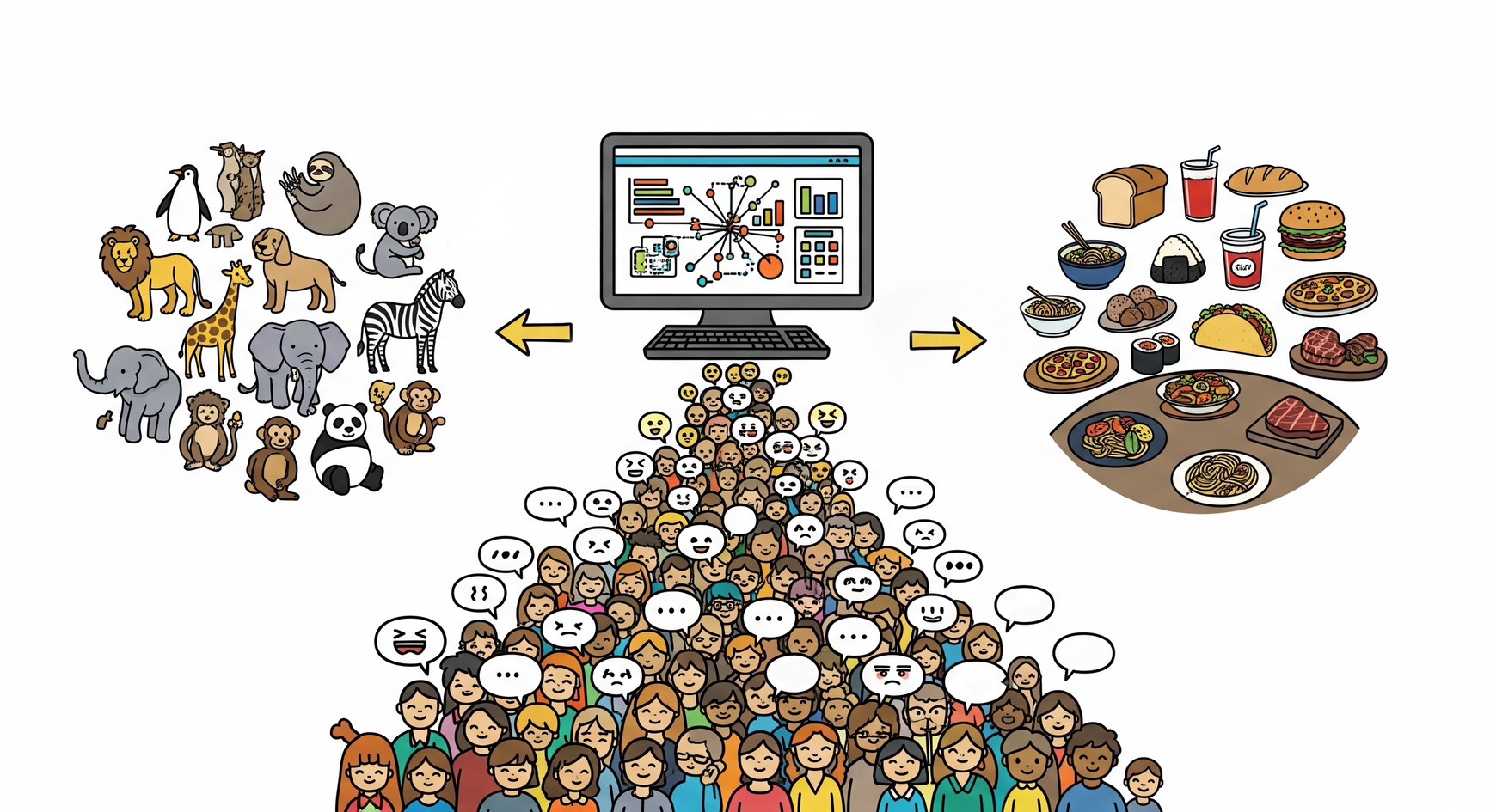

你是否曾經面對過大量網路留言、開放式問卷或顧客評論,想知道人們到底在關心什麼、討論什麼,卻苦無頭緒?在這個資訊快速流通的時代裡,每天都有無數人在網路上發聲,無論是貼文留言、評論、開放式問卷,或者是一場活動後的反饋表單等。文字數據大量湧現,卻往往成為一種難以分析的「資料黑洞」。

面對龐雜的文字洪流,無論是推動活動、倡導議題,或是經營一間在意消費者反饋的店鋪,要如何梳理以及理解群眾在說什麼——找出那些可能被忽略的訊號、情緒與觀點、萃取有意義的趨勢與主題,成了當代重要的能力。而這時,我們可以借助人工智慧的力量,讓電腦來「讀懂」這些海量文字背後所具備的意涵。

這篇文章,便從這個問題出發,帶大家認識一套能協助我們「讀懂群眾語言」的工具——BERTopic。

近年來,一個名為 BERTopic 的工具,逐漸成為學界與業界處理文本分析的重要利器。它不僅能夠從成千上萬則文字中自動找出主題、標示關鍵詞,甚至還能追蹤主題隨著時間而產生的變化。本文將帶你認識這個強大的工具,並看看它如何幫助我們,從「文字的海洋」中找出有意義的主題島嶼。

|BERTopic 有什麼特別的?

BERTopic 是近年快速崛起的主題建模工具,它獨特之處在於它能夠「理解語意」,不僅僅只是比對字詞出現的頻率。

以傳統主題模型( LDA)為例,它只能根據單詞的表面來比對關聯性。例如「海灘」和「衝浪」是兩個不同的詞彙,它們就被視為無相關;但 BERTopic 使用語意模型,可以理解「衝浪板」與「浪點」其實都與海邊活動有關,進而把它們歸為同一主題。

|什麼是主題建模(Topic Modeling)?

LDA 是什麼? LDA (Latent Dirichlet Allocation) 是一種主題建模的演算法,由 Blei 等人在 2003 年提出,專門用來分析大量的文字資料(例如文件集、問卷、評論),主要依賴「詞袋模型 」。它在檢視一篇文章時,會先假設每篇文章背後藏有數個潛在主題,而每個主題中有一些語意上相近的字詞。它會自動找出使用了哪些詞、哪些字詞常一起出現裡、各出現了幾次、進一步去推測這些字詞可能屬於相同主題,但不會管詞語的順序或上下文的意義。例如,在 LDA 眼中,「我愛你」和「你愛我」是完全一樣的,因為它們都包含「我」、「愛」、「你」這三個詞。這種不理解語義的特性,正是 LDA 的主要限制,也凸顯了 BERTopic 的獨特優勢。

詞袋模型: 詞袋模型(Bag-of-Words)是一種經典的文字處理方法,用來將文字轉換成電腦可以理解的「數字向量」。它的最大特色是:不考慮詞的順序與文法,只關心詞彙的出現與頻率。也就是說:LDA 不在乎「我愛臺灣」還是「臺灣愛我」,它只在意「我、愛、臺灣」這三個字有出現過,故其最大的限制是「不懂語意」。 |

這個流程結合了幾種人工智慧技術:

- BERT 語意模型:由 Google 開發,能將整句話轉換成語意向量,讓電腦可以判斷「句子彼此有多像」。

- UMAP 降維技術:將這些高維度的語意向量,壓縮成 2~5 維空間,方便分群。

- HDBSCAN 分群演算法:自動找出語意密集的群組,不需事先設定主題數量。

- TF- IDF 主題關鍵詞計算:自動列出每個主題中最具代表性的關鍵字,幫助人類解讀結果。

這些技術的整合,讓 BERTopic 得以準確分群,還能解釋結果、視覺化趨勢,成為目前主題建模領域中的新興工具。

BERT 是什麼? BERT (Bidirectional Encoder Representations from Transformers) 是 Google 開發的語言模型,它的厲害之處在於能「理解上下文」。

|

「降維」是什麼?

前面提到,語意向量是一個「多維度」的座標,這個維度可能高達數百甚至上千維。而人類很難想像超過三維的空間,電腦要計算這麼多維度的距離也非常耗時。所以「降維 (Dimensionality Reduction)」就像是把一個複雜的3D立體物件,拍成一張2D的平面照片。雖然照片是平面的(維度降低了),但你仍然可以從中看出物件的主要形狀和結構。而UMAP 它能將上百維的向量座標,壓縮到只有2維或3維,同時盡可能地保持原始資料中「誰和誰靠近、誰和誰遠離」的相對關係。這樣一來,電腦就能更輕鬆地在低維度空間中進行分群。 |

HDBSCAN 分群演算法是什麼?

|

TF-IDF是什麼?

TF-IDF (Term Frequency-Inverse Document Frequency) 是一種幫助我們找出「這篇文章裡最能代表主題的關鍵字」的方式,它是由兩個概念組合而成:

將 TF 和 IDF 這兩項分數相乘後,得到的分數越高,代表這個詞越能「代表」這個主題的獨特性,因為這個詞既同時滿足了「在這個文件裡很活躍 (高 TF)」並且「在其他文件中很罕見 (高 IDF)」這兩個條件時才能得到高的總分。

|

|BERTopic 可以應用在哪些領域?

只要你手上擁有大量的文字資料,幾乎都用得上 BERTopic。以下是幾個實際的應用例子:

民意與公共政策分析:

蒐集來自 Google Maps 或 Facebook 上的評論,分析民眾對公園、工程、展覽的看法。例如城市治理單位可以用來民眾對於新設施的反應。用來觀察分析新設施的接受度與爭議點。

教育與社會研究:

分析學生課程回饋或社會調查的開放式回答,找出常見問題、學習動機或改善建議。

品牌與行銷分析:

將產品評論或客服紀錄餵給 BERTopic,快速瞭解消費者關心的焦點,例如價格、功能、客服體驗等。

媒體與新聞追蹤:

觀察一段時間內,新聞或社群媒體上的議題分布與轉變趨勢,例如疫情報導在不同行政區的關鍵詞變化。

|如何操作 BERTopic ?

BERTopic 是用 Python 撰寫的開源套件,操作需要有基本的 Python 語法與執行環境。不過,它的使用流程其實非常直觀,通常只需要:

- 準備一組文字資料,例如留言、評論、逐字稿等。

- 建立並訓練模型:這裡的「訓練」指的是讓模型從資料中自動找出語意規律與主題群組,是一種無監督學習

- 查看主題與關鍵詞

- 使用內建圖表功能進行視覺化,例如主題分布圖、時間變化圖等。

機器學習的「學習方式」主要可以分為兩大主流類型:監督式學習與無監督學習。 一、監督學習:它的任務是根據過去的經驗,對新的、未知的資料做出準確的預測。就像小學生寫作業時,老師已經告訴你「正確答案」是什麼,機器學習模型會從這些已經標記好輸入與輸出的資料中學習,學會預測新的資料會是什麼結果。例如:你給電腦一千張有「貓」標籤的照片和一千張有「狗」標籤的照片,讓它學習如何分辨貓和狗,你已經先準備好「標準答案」給它學習。

|

|結語:讓電腦幫你讀懂群眾聲音

我們身處於一個文字數據浩瀚的時代,每天都在產出與接收大量的文字,每一則訊息、每一段評論,都藏著民眾的情感、需求與觀點。如果能善用工具,這些原本看似雜亂無章的資料,也都將成為非常珍貴的知識來源。

BERTopic 猶如一座橋樑,連接「文字的洪流」與「洞察的彼岸」,它賦予了電腦理解語意、自動分群的智慧,使我們得以跨越資訊的藩籬,得以聆聽群眾的聲音,理解集體經驗的內在結構。不論你是研究者、社會工作者、政策制定者,還是品牌經營者,只要你想知道「大家到底在說什麼」的謎題,BERTopic 無疑是一個值得一試的工具。

|參考資料

- Amazon Web Services. (n.d.). 監督式機器學習和非監督式機器學習有何區別?. 取自 https://aws.amazon.com/tw/compare/the-difference-between-machine-learning-supervised-and-unsupervised/ (檢索日期:2025 年 6 月 13 日)

- Blei, D. M., Ng, A. Y., & Jordan, M. I. (2003). Latent Dirichlet allocation. Journal of Machine Learning Research, 3(Jan), 993-1022.

- Campello, R. J. G. B., Kröger, P., Sander, J., & Zimek, A. (2020). Density-based clustering. Wiley Interdisciplinary Reviews: Data Mining and Knowledge Discovery, 10(2), Article e1343. https://doi.org/10.1002/widm.1343

- Google AI Blog. (2018, November 11). Open Sourcing BERT: State-of-the-Art Pre-training for Natural Language Processing. 取自 https://ai.googleblog.com/2018/11/open-sourcing-bert-state-of-art-pre.html (檢索日期:2025 年 6 月 11 日)

- hdbscan. (n.d.). How HDBSCAN Works. 取自 https://hdbscan.readthedocs.io/en/latest/how_hdbscan_works.html (檢索日期:2025 年 6 月 12 日)

- IBM. (n.d.-a). What is supervised learning? What is unsupervised learning?. 取自 https://www.ibm.com/think/topics/supervised-vs-unsupervised-learning (檢索日期:2025 年 6 月 13 日)

- IBM. (n.d.-b). Bag-of-Words. 取自 https://www.ibm.com/think/topics/bag-of-words (檢索日期:2025 年 6 月 11 日)

- Jurafsky, D., & Martin, J. H. (2025a). Vector Semantics and Embeddings (Draft of January 12, 2025). In Speech and Language Processing. 取自 https://web.stanford.edu/~jurafsky/slp3/6 (檢索日期:2025 年 6 月 12 日)

- Manning, C. D., Raghavan, P., & Schütze, H. (2008). Introduction to Information Retrieval. Cambridge University Press.

- McInnes, L., Healy, J., & Melville, J. (2018). UMAP: Uniform Manifold Approximation and Projection for Dimension Reduction. arXiv preprint arXiv:1802.03426. https://arxiv.org/abs/1802.03426